Accrochez-vous, l’IA passe à la vitesse supérieure ! Les derniers benchmarks MLPerf Inference V5.0, qui simulent des scénarios d’inférence ultra-complexes, viennent de tomber, et NVIDIA Blackwell a tout simplement pulvérisé les records. Cerise sur le gâteau : c’est la première fois que NVIDIA soumettait son système GB200 NVL72, une solution rack pensée pour l’inférence IA à grande échelle.

Des « usines à intelligence » pour alimenter le futur

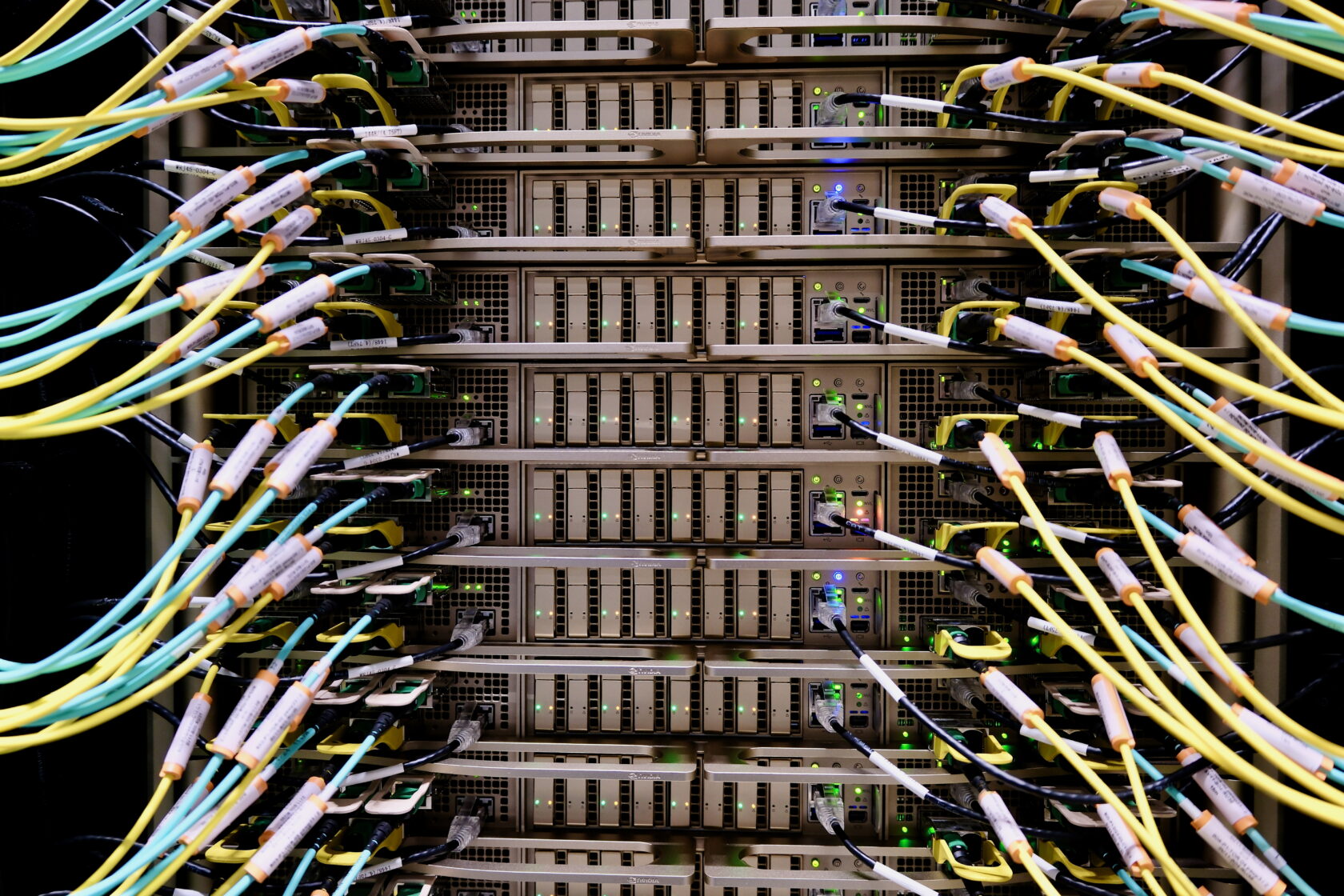

Pour exploiter pleinement le potentiel de l’IA de pointe, il faut une infrastructure informatique révolutionnaire : les « usines à intelligence ». Oubliez les data centers classiques, ces usines ne se contentent pas de stocker et de traiter des données. Elles fabriquent de l’intelligence à la chaîne, transformant des données brutes en informations exploitables en temps réel.

L’objectif est simple : fournir des réponses précises, rapidement, au moindre coût et au plus grand nombre. Mais derrière cette simplicité apparente se cache une complexité redoutable.

Avec des modèles d’IA atteignant des milliards, voire des milliers de milliards de paramètres pour des réponses toujours plus pertinentes, la puissance de calcul nécessaire explose. Résultat : moins de réponses générées et un coût par réponse qui grimpe. Maintenir un débit d’inférence élevé et un coût par réponse bas exige donc une innovation constante à tous les niveaux : puces, réseaux et logiciels.

MLPerf Inference V5.0 : un défi de taille

La dernière version de MLPerf Inference, le benchmark de référence pour l’inférence IA, intègre désormais Llama 3.1 405B, l’un des modèles open-source les plus imposants et complexes à exécuter. Le nouveau benchmark Llama 2 70B Interactive impose des exigences de latence bien plus strictes que l’ancien Llama 2 70B, reflétant mieux les contraintes des déploiements en production pour une expérience utilisateur optimale.

Outre Blackwell, la plateforme NVIDIA Hopper a également brillé, avec des performances en forte hausse sur Llama 2 70B grâce à des optimisations globales.

Blackwell, le nouveau champion de l’inférence

Le système GB200 NVL72, qui connecte 72 GPU Blackwell pour fonctionner comme un seul GPU géant, a atteint un débit jusqu’à 30 fois supérieur sur le benchmark Llama 3.1 405B par rapport au H200 NVL8. Un exploit réalisé grâce à des performances par GPU plus que triplées et un domaine d’interconnexion NVIDIA NVLink 9 fois plus large.

Si de nombreuses entreprises utilisent MLPerf pour évaluer leurs performances, seuls NVIDIA et ses partenaires ont soumis et publié des résultats sur Llama 3.1 405B.

En production, la latence est un facteur crucial, notamment pour le temps de réponse au premier jeton (TTFT) et le temps par jeton de sortie (TPOT). Le nouveau benchmark Llama 2 70B Interactive, avec un TPOT 5 fois plus court et un TTFT 4,4 fois plus faible, simule une expérience utilisateur plus réactive. Sur ce test, le système NVIDIA DGX B200 avec huit GPU Blackwell a triplé les performances par rapport à huit GPU H200, plaçant la barre très haut.

L’architecture Blackwell et son stack logiciel optimisé atteignent des niveaux de performance inédits, ouvrant la voie à des usines à intelligence plus performantes, avec un débit accru et des taux de génération de jetons plus rapides.

Hopper, toujours dans la course

L’architecture Hopper, lancée en 2022, reste un pilier des usines à inférence actuelles et continue d’alimenter l’entraînement des modèles. Grâce à des optimisations logicielles continues, NVIDIA améliore le débit des usines à IA basées sur Hopper, offrant ainsi une valeur ajoutée constante.

Sur le benchmark Llama 2 70B, introduit il y a un an dans MLPerf Inference v4.0, le débit du GPU H100 a augmenté de 50%. Le GPU H200, basé sur la même architecture avec une mémoire plus grande et plus rapide, porte cette augmentation à 60%.

Hopper a également exécuté tous les benchmarks, y compris les nouveaux Llama 3.1 405B, Llama 2 70B Interactive et les tests de réseaux neuronaux graphiques. Cette polyvalence lui permet de gérer un large éventail de charges de travail et de s’adapter à l’évolution des modèles et des scénarios d’utilisation.

Un écosystème florissant

Lors de ce MLPerf, 15 partenaires ont soumis d’excellents résultats sur la plateforme NVIDIA, dont ASUS, Cisco, CoreWeave, Dell Technologies, Fujitsu, Giga Computing, Google Cloud, Hewlett Packard Enterprise, Lambda, Lenovo, Oracle Cloud Infrastructure, Quanta Cloud Technology, Supermicro, Sustainable Metal Cloud et VMware.

L’étendue de ces soumissions témoigne de la portée de la plateforme NVIDIA, disponible auprès de tous les fournisseurs de services cloud et fabricants de serveurs du monde entier.

L’évolution constante du benchmark MLPerf Inference par MLCommons, en phase avec les dernières avancées de l’IA, et la fourniture de données de performance rigoureuses et évaluées par des pairs sont essentielles pour aider les décideurs IT à choisir l’infrastructure IA optimale.

Images et vidéo prises dans un centre de données Equinix en Silicon Valley.