L’IA est partout, et NVIDIA Research est en première ligne pour la faire avancer. À la conférence ICLR de Singapour, ils ont déballé un arsenal d’innovations qui promettent de révolutionner des domaines allant des voitures autonomes à la création artistique. Accrochez-vous, ça va décoiffer !

Des cerveaux en fusion pour l’IA de demain

NVIDIA Research, avec ses 400 experts, ne chôme pas. Présents à l’International Conference on Learning Representations (ICLR), ils ont présenté plus de 70 articles. L’objectif ? Booster l’IA à tous les niveaux, du hardware au software, pour des applications concrètes dans un maximum de secteurs.

Bryan Catanzaro, vice-président de la recherche en deep learning appliqué chez NVIDIA, souligne l’importance de cette conférence : « ICLR est l’une des conférences sur l’IA les plus influentes au monde. Les recherches que nous y présentons cette année visent à accélérer chaque niveau de la pile informatique pour amplifier l’impact et l’utilité de l’IA dans tous les secteurs. »

Des défis réels, des solutions innovantes

NVIDIA a dévoilé des avancées majeures, notamment dans l’IA générative multimodale et les méthodes d’entraînement. Voici un aperçu des projets les plus marquants :

- Fugatto : Imaginez une IA capable de générer ou de transformer n’importe quel mix de musique, de voix et de sons, simplement à partir de descriptions textuelles et de fichiers audio. C’est Fugatto ! D’autres modèles NVIDIA présentés à ICLR améliorent la compréhension de la parole par les grands modèles de langage audio (LLM).

- HAMSTER : Ce projet explore une architecture hiérarchique pour les modèles vision-langage-action. L’idée ? Améliorer le transfert de connaissances à partir de données d’entraînement « low-cost » pour optimiser les compétences des robots.

- Hymba : Cette famille de petits modèles de langage hybrides combine les avantages des modèles Transformer et des modèles d’espace d’état. Résultat : une meilleure mémoire, une synthèse efficace du contexte et un raisonnement plus logique. Le tout, 3 fois plus rapidement et avec une utilisation du cache réduite de près de 4 fois.

- LongVILA : Entraîner des IA sur de longues vidéos est gourmand en ressources. LongVILA propose une solution pour paralléliser efficacement l’entraînement et l’inférence, avec une scalabilité jusqu’à 2 millions de jetons sur 256 GPU. Performances record garanties !

- LLaMaFlex : Ce projet introduit une nouvelle technique pour créer des familles de LLM compressés à partir d’un seul grand modèle. Plus précis que les modèles existants, LLaMaFlex pourrait réduire considérablement le coût de l’entraînement.

- Proteina : Ce modèle peut générer des squelettes de protéines, la structure qui maintient une protéine ensemble. Il utilise une architecture de modèle Transformer avec jusqu’à 5 fois plus de paramètres que les modèles précédents.

- SRSA : Au lieu d’apprendre à partir de zéro, les robots pourraient adapter leurs compétences existantes à de nouvelles tâches. C’est le pari de SRSA, qui améliore les taux de réussite sur des tâches inédites de 19 %.

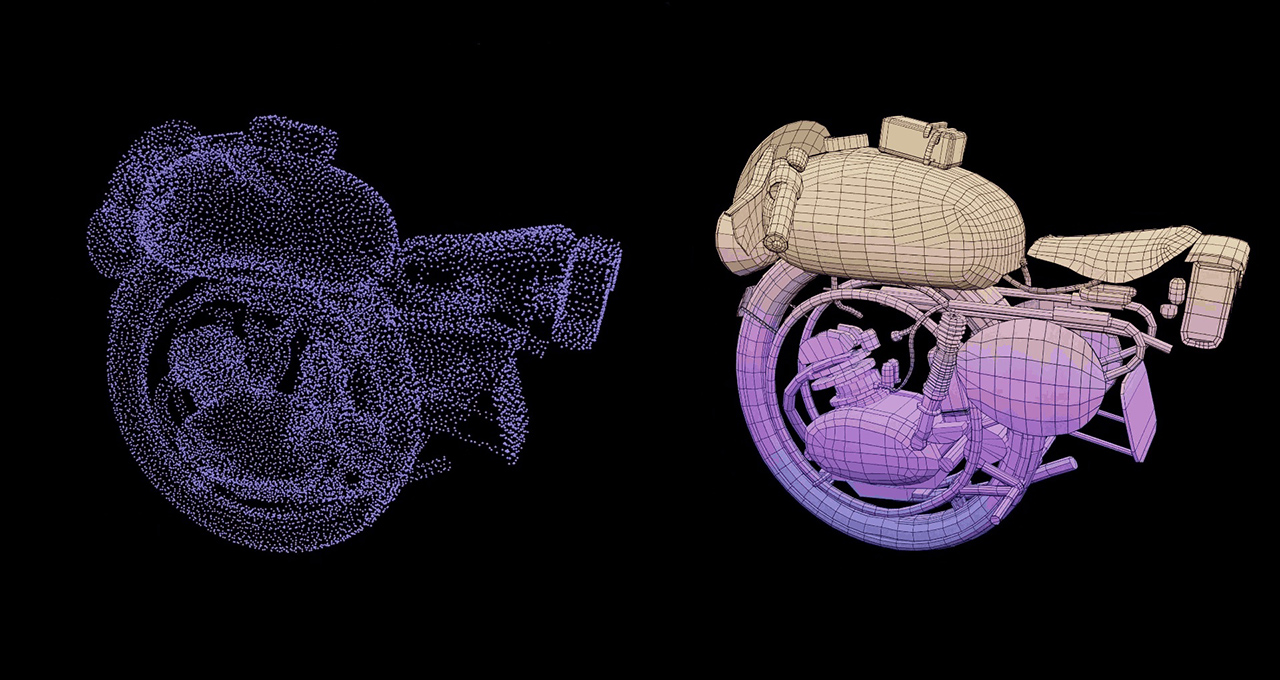

- STORM : Reconstituer des scènes extérieures dynamiques (voitures en mouvement, arbres qui se balancent) en 3D à partir de quelques images ? C’est possible avec STORM, qui ouvre des perspectives intéressantes pour le développement des véhicules autonomes.

L’IA, un terrain de jeu sans limites

NVIDIA Research explore des pistes fascinantes et repousse les limites de l’IA. Leurs travaux à ICLR témoignent d’une ambition claire : rendre l’IA plus performante, plus accessible et plus utile pour tous.