L’intelligence artificielle est en constante évolution, et les modèles de langage ouverts (LLM) se démocratisent rapidement. Dans ce contexte, NVIDIA et OpenAI s’associent pour rendre les nouveaux modèles open-source gpt-oss accessibles et performants sur les GPU NVIDIA GeForce RTX et RTX PRO. Cette collaboration marque une étape importante dans l’accessibilité de l’IA, permettant aux développeurs et aux passionnés de l’IA de bénéficier de capacités de raisonnement avancées, directement sur leurs machines locales.

L’annonce de cette optimisation est significative, car elle promet une inférence intelligente et rapide, aussi bien depuis le cloud que sur les PC. Cette initiative ouvre de nouvelles perspectives pour le développement d’applications d’IA « agentic » telles que la recherche web, l’analyse approfondie et bien d’autres. L’optimisation des modèles gpt-oss pour les GPU NVIDIA est un pas de plus vers une IA plus accessible et performante pour tous.

L’arrivée des Modèles gpt-oss et leur Potentiel

OpenAI a libéré les modèles gpt-oss-20b et gpt-oss-120b, des modèles de raisonnement à poids ouverts, conçus avec une architecture « mixture-of-experts » (MoE). Ces modèles sont dotés de capacités de « chain-of-thought » et permettent d’ajuster le niveau d’effort de raisonnement. Ils supportent également des fonctionnalités comme le suivi d’instructions et l’utilisation d’outils. Ces modèles ont été entraînés sur des NVIDIA H100 GPUs [https://www.nvidia.com/en-us/data-center/h100/], ce qui témoigne de la puissance de calcul nécessaire pour leur développement.

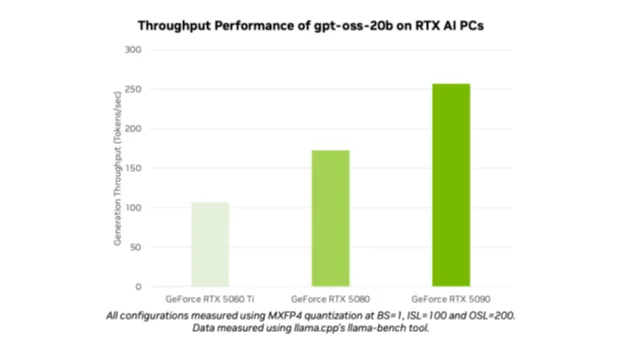

L’un des points forts de ces modèles est leur capacité à gérer de longues séquences contextuelles, jusqu’à 131 072 tokens, ce qui est particulièrement utile pour les tâches nécessitant une compréhension approfondie du contexte, comme la recherche web, l’aide à la programmation, la compréhension de documents et la recherche approfondie. De plus, ces modèles sont les premiers à être optimisés pour le format MXFP4 sur les GPU NVIDIA RTX, offrant une haute qualité de modèle tout en étant plus performants et moins gourmands en ressources que d’autres types de précision.

L’optimisation NVIDIA pour une Expérience Utilisateur Simplifiée

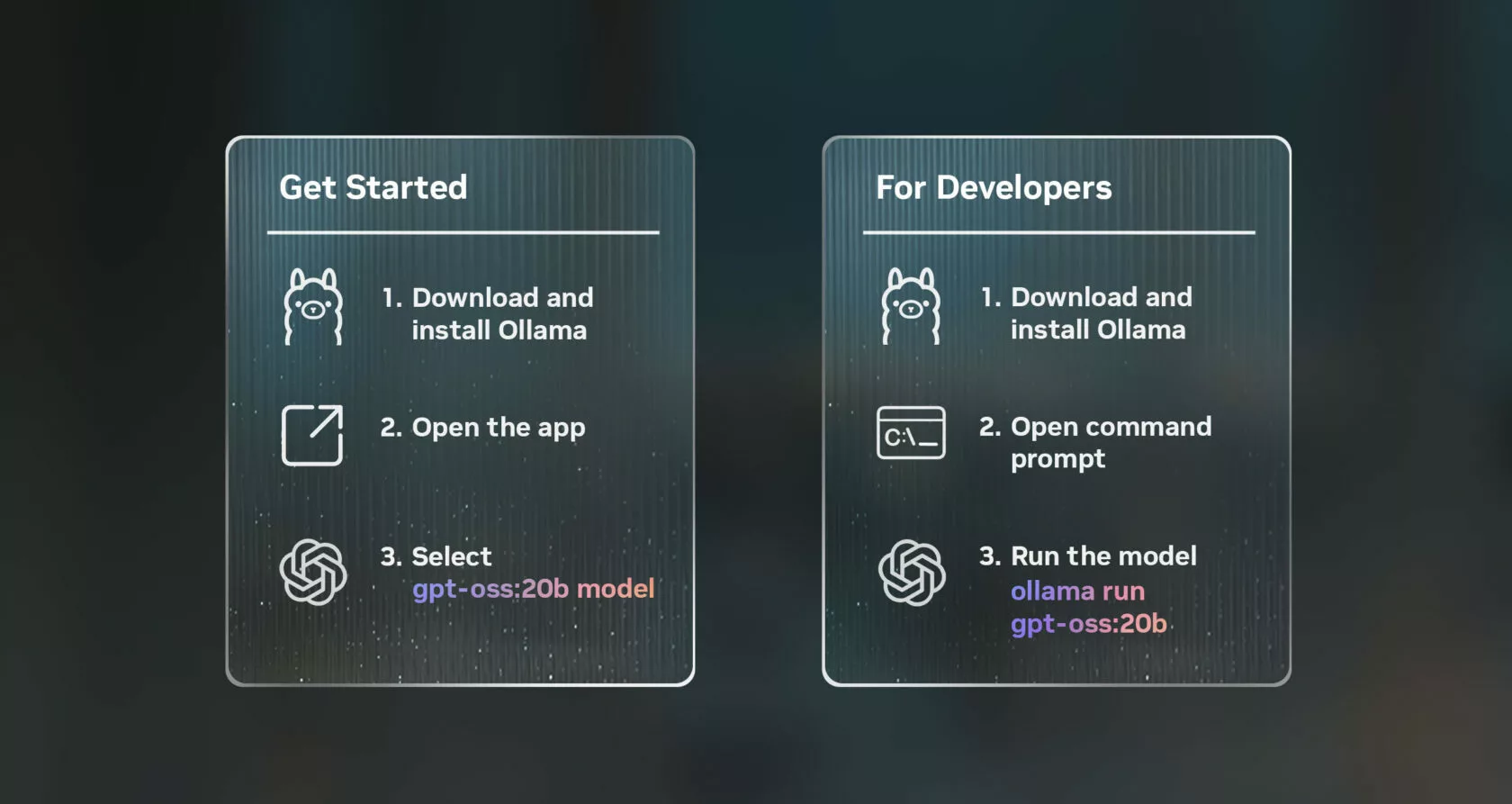

NVIDIA a mis en place des solutions pour faciliter l’utilisation de ces modèles sur les PC équipés de GPU RTX. L’application Ollama est l’une des méthodes les plus simples pour tester ces modèles, nécessitant au moins 24 Go de VRAM. Ollama est appréciée pour sa facilité d’intégration et son interface utilisateur conviviale, offrant un support immédiat pour les modèles open-weight d’OpenAI. Grâce à l’optimisation pour RTX, les utilisateurs peuvent bénéficier de performances optimales sans configuration supplémentaire.

L’application Ollama propose également de nouvelles fonctionnalités, telles que la prise en charge facile des fichiers PDF ou texte, le support multimodal et la personnalisation des longueurs de contexte. Les développeurs peuvent également utiliser Ollama via l’interface de ligne de commande ou le SDK pour intégrer ces modèles dans leurs propres applications et flux de travail. NVIDIA a également travaillé avec la communauté open-source pour optimiser les performances sur les GPU RTX via llama.cpp et la bibliothèque tensorielle GGML. Ces contributions incluent l’implémentation de CUDA Graphs [https://developer.nvidia.com/blog/cuda-graphs/] pour réduire la surcharge et l’ajout d’algorithmes pour diminuer les charges processeur.

Autres Méthodes d’Utilisation et Perspectives d’Avenir

En dehors d’Ollama, les passionnés et les développeurs peuvent également utiliser les modèles gpt-oss sur les PC RTX AI via d’autres applications et frameworks, avec un minimum de 16 Go de VRAM. Les développeurs Windows peuvent également accéder aux nouveaux modèles d’OpenAI via Microsoft AI Foundry Local, actuellement en préversion publique. Foundry Local est une solution d’inférence d’IA sur appareil qui s’intègre aux flux de travail via la ligne de commande, le SDK ou les API. Foundry Local utilise ONNX Runtime, optimisé par CUDA, avec la prise en charge de NVIDIA TensorRT pour RTX, qui arrivera prochainement.

Cette initiative marque le début d’une nouvelle vague d’innovation en matière d’IA, permettant aux développeurs d’intégrer des capacités de raisonnement dans leurs applications Windows accélérées par l’IA. NVIDIA continue de soutenir la communauté en proposant des ressources et des informations via le blog RTX AI Garage et d’autres plateformes. L’objectif est de faciliter l’apprentissage et la mise en œuvre de solutions basées sur l’IA, ouvrant la voie à de nouvelles applications créatives et productives.

Conclusion

La collaboration entre NVIDIA et OpenAI pour optimiser les modèles gpt-oss pour les GPU RTX représente une avancée significative dans le domaine de l’IA. En rendant ces modèles open-source plus accessibles et performants, NVIDIA permet aux développeurs et aux utilisateurs finaux d’explorer de nouvelles possibilités, des applications d’IA « agentic » à la recherche avancée. Cette initiative souligne l’engagement de NVIDIA à soutenir l’innovation et à démocratiser l’accès à l’IA, ouvrant la voie à un avenir où l’intelligence artificielle est plus accessible et intégrée dans notre quotidien.

Avec des outils comme Ollama et d’autres solutions open-source, ainsi que le support continu de NVIDIA, les passionnés et les développeurs ont désormais les moyens de créer et d’expérimenter avec les modèles d’IA de pointe, stimulant ainsi l’innovation et ouvrant de nouvelles perspectives pour l’avenir de la technologie.