L’intelligence artificielle est en pleine effervescence, et avec elle, une révolution silencieuse transforme le paysage technologique mondial. Les « AI factories », ou usines d’IA, émergent à une vitesse fulgurante, redéfinissant les règles du jeu en matière de calcul intensif. Ces centres de données nouvelle génération ne se contentent pas d’héberger des sites web ou des boîtes mail ; ils sont conçus pour entraîner et déployer l’intelligence artificielle elle-même. Cette nouvelle ère exige des infrastructures radicalement différentes, et les réseaux informatiques sont au cœur de cette transformation.

Les géants du web ont déjà investi des milliards dans des infrastructures d’IA à grande échelle, et les entreprises se bousculent pour construire leurs propres « AI foundries ». Les gouvernements emboîtent le pas, désireux d’exploiter le potentiel de l’IA pour la médecine personnalisée et les services linguistiques adaptés à leurs populations. Ces usines d’IA, véritables moteurs de calcul, sont assemblées à partir de dizaines, voire de centaines de milliers de GPU, orchestrés comme une entité unique. L’orchestration devient ainsi l’élément crucial de la performance.

Le Data Center, Nouveau Centre de Calcul

Le data center est devenu la nouvelle unité de calcul, et la manière dont les GPU sont connectés définit ses capacités. Une architecture réseau unique ne suffit plus. Il faut une conception en couches intégrant des technologies de pointe, comme la photonique sur silicium (co-packaged silicon photonics) qui semblait relever de la science-fiction il y a peu. La complexité n’est pas un défaut, mais une caractéristique essentielle. Si les couches réseau sont mal conçues, toute la machine s’arrête. Bien conçues, elles permettent des performances extraordinaires.

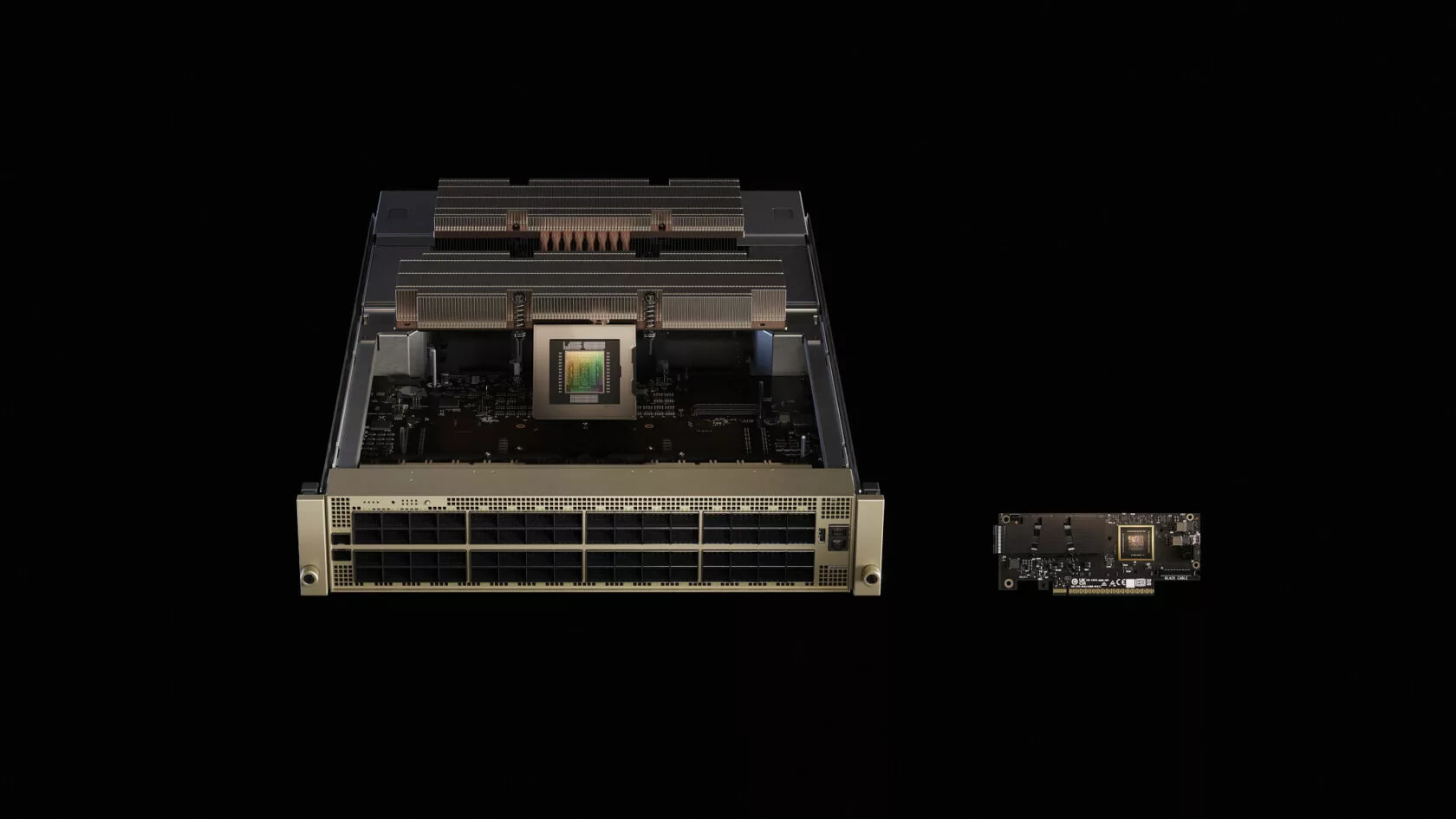

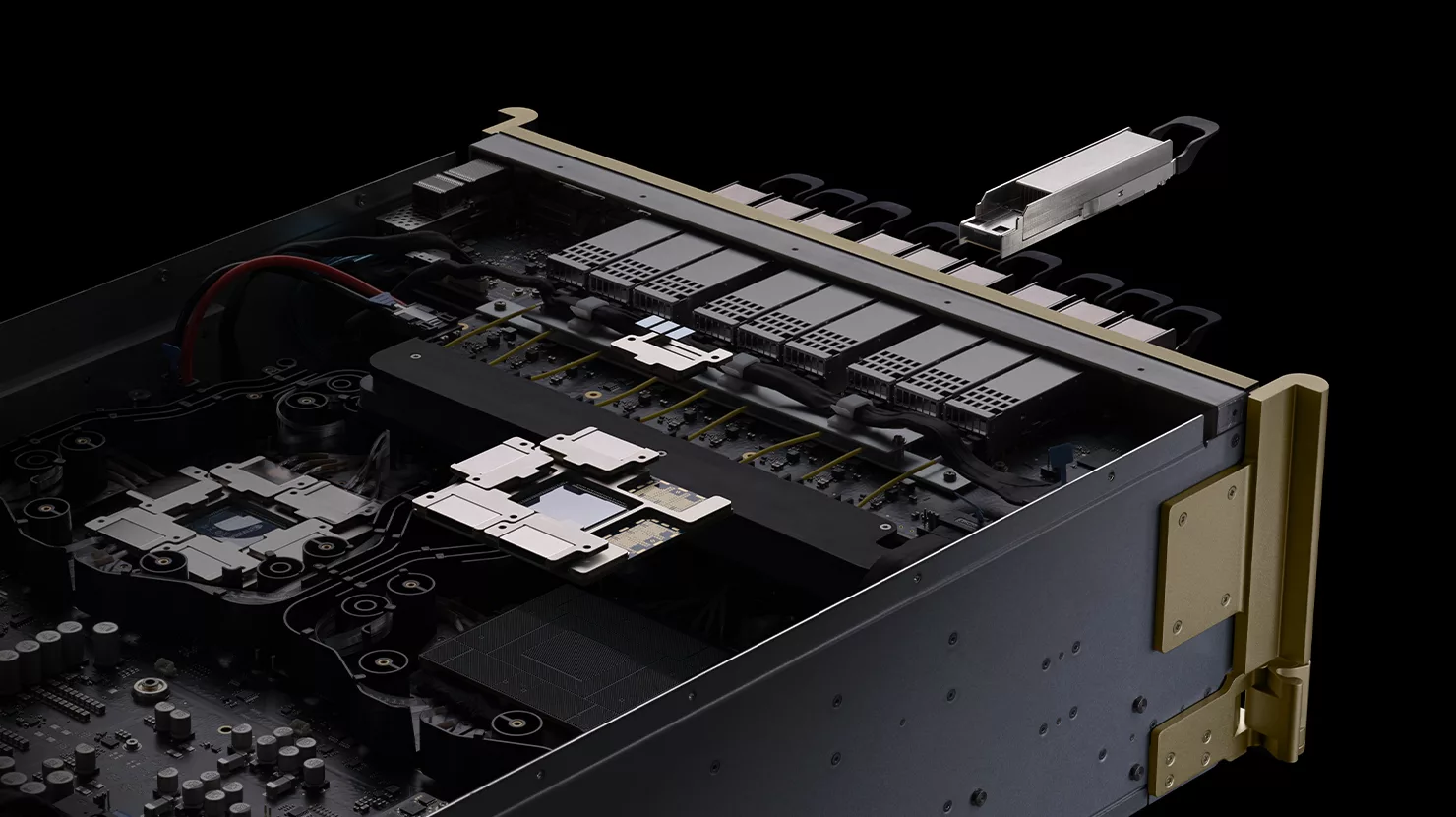

Cette évolution s’accompagne d’une transformation physique. Les puces, autrefois conçues pour être légères, sont désormais intégrées dans des structures massives, comme l’épine dorsale en cuivre d’un rack de serveurs. Les manifolds refroidis par liquide, les barres omnibus personnalisées et les épines dorsales en cuivre sont indispensables. L’IA exige désormais du matériel à grande échelle, de nature industrielle. Plus les modèles sont complexes, plus ces machines doivent être étendues.

Par exemple, la structure NVIDIA NVLink est construite à partir de plus de 5 000 câbles coaxiaux, méticuleusement torsadés et acheminés. Elle déplace plus de données par seconde que l’ensemble de l’internet. Cela représente 130 To/s de bande passante GPU-à-GPU, entièrement maillée. Ce n’est pas simplement rapide, c’est fondamental. La super autoroute de l’IA se trouve désormais à l’intérieur du rack.

InfiniBand vs Ethernet : Le Choix des Réseaux

L’entraînement des grands modèles de langage (LLM) modernes qui alimentent l’IA ne se limite pas à l’utilisation d’une seule machine. Il s’agit d’orchestrer le travail de dizaines, voire de centaines de milliers de GPU, les piliers du calcul IA. Ces systèmes reposent sur le calcul distribué, qui répartit les calculs massifs sur des nœuds (serveurs individuels), chaque nœud traitant une partie de la charge de travail. Lors de l’entraînement, ces parties, généralement d’énormes matrices de nombres, doivent être régulièrement fusionnées et mises à jour. Cette fusion se produit via des opérations collectives, telles que « all-reduce » (qui combine les données de tous les nœuds et redistribue le résultat) et « all-to-all » (où chaque nœud échange des données avec tous les autres nœuds).

Ces processus sont sensibles à la vitesse et à la réactivité du réseau, ce que les ingénieurs appellent la latence (délai) et la bande passante (capacité de données), ce qui peut provoquer des arrêts lors de l’entraînement. Pour l’inférence, qui consiste à exécuter des modèles entraînés pour générer des réponses ou des prédictions, les défis s’inversent. Les systèmes de génération augmentée par la recherche, qui combinent les LLM avec la recherche, exigent des recherches et des réponses en temps réel. Dans les environnements cloud, l’inférence multi-locataires signifie que les charges de travail de différents clients doivent fonctionner sans problème, sans interférence. Cela nécessite une mise en réseau ultra-rapide et à haut débit, capable de gérer une demande massive avec une isolation stricte entre les utilisateurs. L’Ethernet traditionnel, conçu pour les charges de travail sur un seul serveur, ne répond pas aux exigences de l’IA distribuée.

C’est pourquoi la mise en réseau InfiniBand est la norme de référence pour les supercalculateurs et les usines d’IA. Avec NVIDIA Quantum InfiniBand, les opérations collectives s’exécutent à l’intérieur du réseau lui-même en utilisant la technologie Scalable Hierarchical Aggregation and Reduction Protocol (SHARP), doublant la bande passante des réductions. Il utilise le routage adaptatif et le contrôle de la congestion basé sur la télémétrie pour répartir les flux sur les chemins, garantir une bande passante déterministe et isoler le bruit. Ces optimisations permettent à InfiniBand d’adapter la communication de l’IA avec précision. Pour les clusters couvrant des dizaines de racks, les commutateurs NVIDIA Quantum-X800 InfiniBand repoussent les limites d’InfiniBand. Chaque commutateur fournit 144 ports de connectivité à 800 Gbit/s, avec SHARPv4 basé sur du matériel, un routage adaptatif et un contrôle de la congestion basé sur la télémétrie. La plateforme intègre la photonique sur silicium (co‑packaged silicon photonics) pour minimiser la distance entre l’électronique et l’optique, réduisant la consommation d’énergie et la latence. Associée aux NVIDIA ConnectX-8 SuperNICs offrant 800 Gbit/s par GPU, cette structure relie des modèles à des billions de paramètres et alimente le calcul intégré au réseau. Pour en savoir plus, consultez : NVIDIA Quantum‑X800.

Cependant, les hyperscalers et les entreprises ont investi des milliards dans leur infrastructure logicielle Ethernet. Ils ont besoin d’une solution rapide qui utilise l’écosystème existant pour les charges de travail d’IA. C’est là qu’intervient NVIDIA Spectrum-X : un nouveau type d’Ethernet conçu spécifiquement pour l’IA distribuée. Pour en savoir plus, consultez : NVIDIA Spectrum‑X.

NVIDIA Spectrum-X : L’Ethernet Réinventé pour l’IA

Lancé en 2023, Spectrum-X offre une mise en réseau sans perte, un routage adaptatif et une isolation des performances. Le commutateur SN5610, basé sur l’ASIC Spectrum-4, prend en charge des vitesses de port allant jusqu’à 800 Gbit/s et utilise le contrôle de congestion de NVIDIA pour maintenir un débit de données de 95 % à grande échelle. Spectrum-X est un Ethernet entièrement basé sur les normes. En plus de prendre en charge Cumulus Linux, il prend en charge le système d’exploitation réseau SONiC open source, offrant ainsi une flexibilité aux clients. Un ingrédient clé est les NVIDIA SuperNICs, basées sur NVIDIA BlueField-3 ou ConnectX-8, qui fournissent jusqu’à 800 Gbit/s de connectivité RoCE et déchargent le réordonnancement des paquets et la gestion de la congestion. Spectrum-X apporte les meilleures innovations d’InfiniBand, comme le contrôle de la congestion basé sur la télémétrie, l’équilibrage de charge adaptatif et le placement direct des données, à Ethernet, permettant aux entreprises de s’étendre à des centaines de milliers de GPU. Les systèmes à grande échelle avec Spectrum-X, y compris le supercalculateur d’IA le plus colossal au monde, ont atteint un débit de données de 95 % sans dégradation de la latence des applications. Les structures Ethernet standard ne fourniraient qu’environ 60 % de débit en raison des collisions de flux.

Une Approche Modulaire pour l’Évolutivité

Aucun réseau unique ne peut servir chaque couche d’une usine d’IA. L’approche de NVIDIA consiste à adapter la bonne structure à la bonne couche, puis à tout relier avec des logiciels et du silicium. À l’intérieur d’un rack de serveurs, les GPU doivent communiquer entre eux comme s’ils étaient différents cœurs sur la même puce. NVIDIA NVLink et NVLink Switch étendent la mémoire et la bande passante des GPU sur les nœuds. Dans un système NVIDIA GB300 NVL72