La conférence Hot Chips, rendez-vous annuel incontournable pour les architectes de processeurs et de systèmes, se profile à l’horizon. Du 24 au 26 août à l’Université de Stanford, cet événement mettra en lumière les dernières innovations technologiques prêtes à transformer les AI factories et à stimuler le marché des centres de données, estimé à plusieurs milliards de dollars. NVIDIA, acteur majeur du secteur, y présentera ses avancées significatives en matière d’intelligence artificielle, d’inférence et de réseaux.

L’accent sera mis sur la capacité d’inférence de l’IA, une technologie cruciale pour l’analyse et la résolution de problèmes complexes. NVIDIA dévoilera les dernières avancées de ses produits, notamment le NVIDIA ConnectX-8 SuperNIC, les cartes graphiques basées sur l’architecture Blackwell, dont le NVIDIA GeForce RTX 5090 GPU, ainsi que les commutateurs Co-packaged optics (CPO). Ces technologies promettent d’accélérer l’innovation en IA à toutes les échelles, de l’edge computing aux AI factories à l’échelle du gigawatt.

Le Networking NVIDIA au Cœur de l’Innovation IA

Le networking est devenu le système nerveux central des centres de données, reliant les composants essentiels pour créer une unité de calcul performante. Lors de la conférence, Idan Burstein, architecte principal de NVIDIA, détaillera comment les technologies de networking NVIDIA, en particulier le NVIDIA ConnectX-8 SuperNIC (https://www.nvidia.com/en-us/networking/products/ethernet/supernic/), permettent une communication multi-GPU à haute vitesse et à faible latence. Ces superNIC offrent des performances d’inférence inégalées à grande échelle.

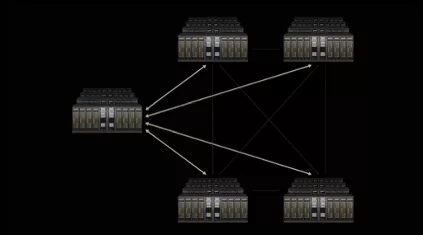

En plus du ConnectX-8, NVIDIA NVLink, NVLink Switch et NVLink Fusion assurent une connectivité optimisée, reliant les GPU et les éléments de calcul au sein des serveurs. Pour la communication à l’échelle du data center, NVIDIA Spectrum-X Ethernet connecte rapidement des ensembles de données massifs aux modèles d’IA, orchestrant la communication GPU-à-GPU. L’extension de cette technologie, Spectrum-XGS Ethernet, permet d’interconnecter plusieurs centres de données distribués pour former des AI factories à l’échelle du gigabyte. Les commutateurs CPO, quant à eux, repoussent les limites de la performance et de l’efficacité pour l’infrastructure IA.

Blackwell et CUDA: L’IA entre les Mains des Développeurs

L’architecture NVIDIA Blackwell, qui alimente le NVIDIA GeForce RTX 5090 GPU (https://www.nvidia.com/en-us/geforce/graphics-cards/50-series/rtx-5090/), promet des avancées majeures en matière de graphisme et de simulation. Marc Blackstein, Senior Director of Architecture chez NVIDIA, expliquera comment ce GPU offre des performances doublées dans les jeux grâce à la technologie DLSS 4, tout en introduisant des fonctionnalités de rendu neuronal pour améliorer le réalisme des graphismes. Cela se traduit par des expériences visuelles fluides, une faible consommation d’énergie et une simulation plus réaliste des personnages et des effets.

NVIDIA CUDA, l’infrastructure de calcul la plus largement accessible au monde, permet aux développeurs de déployer et d’exécuter des modèles d’IA partout. Des systèmes de rack à l’échelle GB200 NVL72 aux PC et stations de travail équipés de GeForce RTX et NVIDIA RTX PRO, en passant par le NVIDIA DGX Spark, alimenté par NVIDIA GB10, CUDA est au cœur de l’écosystème NVIDIA, rendant l’IA accessible à des millions de développeurs.

DGX Spark et l’Innovation Optimisée pour les LLMs

La conférence présentera également le NVIDIA DGX Spark, une solution compacte conçue pour les développeurs, les chercheurs et les data scientists. Andi Skende, ingénieur distingué de NVIDIA, présentera comment DGX Spark permet de repousser les limites de l’IA générative directement sur les postes de travail. Il prend en charge NVFP4, un format numérique de faible précision conçu pour l’inférence efficace des modèles de langage volumineux (LLM). Le DGX Spark, associé à la plateforme NVIDIA Blackwell, promet d’accélérer les charges de travail dans divers secteurs.

NVIDIA favorise la collaboration open-source en accélérant plusieurs bibliothèques et frameworks pour optimiser les charges de travail d’IA pour les LLM et l’inférence distribuée. Des outils comme NVIDIA TensorRT-LLM, NVIDIA Dynamo, TileIR, Cutlass, la NVIDIA Collective Communication Library et NIX sont intégrés dans des millions de flux de travail. NVIDIA collabore également avec des fournisseurs de frameworks open-source pour offrir des optimisations de modèles pour FlashInfer, PyTorch, SGLang, vLLM, et d’autres. De plus, les microservices NVIDIA NIM sont disponibles pour les modèles open source populaires tels que gpt-oss d’OpenAI et Llama 4.

Perspectives et Conclusion

La conférence Hot Chips de cette année promet d’être un événement majeur pour l’industrie technologique. Les présentations de NVIDIA soulignent l’importance croissante de l’inférence, des réseaux et de l’innovation en IA. Les avancées présentées, notamment le NVIDIA ConnectX-8 SuperNIC (https://www.nvidia.com/en-us/networking/products/ethernet/supernic/), le NVIDIA GeForce RTX 5090 GPU (https://www.nvidia.com/en-us/geforce/graphics-cards/50-series/rtx-5090/), et les commutateurs CPO, témoignent de l’engagement de NVIDIA à repousser les limites de l’IA et à permettre des avancées significatives dans divers domaines.

En conclusion, Hot Chips 2024 offrira un aperçu précieux des technologies qui façonneront l’avenir de l’IA et des centres de données. L’approche de NVIDIA, axée sur l’innovation à tous les niveaux, de la performance des GPU à l’optimisation des réseaux, en passant par le soutien aux développeurs, illustre son rôle de leader dans cette révolution technologique. Restez connectés pour plus de détails sur les annonces de NVIDIA. Pour plus d’informations, rendez-vous sur(https://nvidianews.nvidia.com/news/nvidia-introduces-spectrum-xgs-ethernet-to-connect-distributed-data-centers-into-giga-scale-ai-super-factories).