L’intelligence artificielle générative est en pleine effervescence, transformant radicalement l’expérience utilisateur sur PC. Des assistants d’écriture aux outils créatifs en passant par les avatars numériques, l’IA redéfinit les possibilités offertes par nos ordinateurs. Au cœur de cette révolution, NVIDIA et Microsoft collaborent pour optimiser l’utilisation des RTX AI PCs, rendant l’expérimentation et le déploiement de l’IA plus simples et performants. L’alliance de ces deux géants de la tech promet une expérience utilisateur améliorée, avec des performances accrues et une accessibilité accrue pour les développeurs et les utilisateurs finaux.

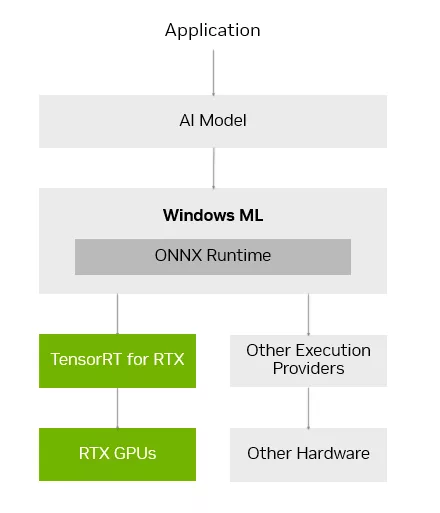

Cette collaboration se concrétise par l’optimisation de NVIDIA TensorRT, une bibliothèque d’inférence d’IA, pour les RTX AI PCs. Cette technologie, combinée à une construction d’engines « just-in-time » sur l’appareil et une taille réduite de 8x, permet un déploiement fluide de l’IA sur plus de 100 millions de PC RTX AI. Annoncé lors de Microsoft Build, TensorRT pour RTX est nativement pris en charge par Windows ML, une nouvelle pile d’inférence offrant aux développeurs une compatibilité matérielle étendue et des performances de pointe. En d’autres termes, les applications peuvent tirer parti de l’accélération matérielle des cartes graphiques RTX sans avoir à se soucier des optimisations complexes.

Accélération de l’Inférence IA avec TensorRT pour RTX

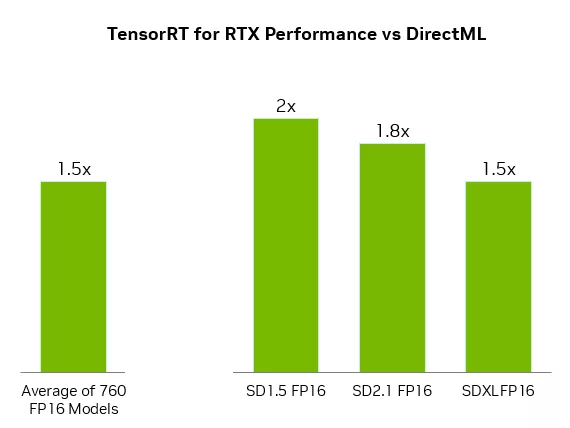

L’un des principaux défis pour les développeurs de logiciels d’IA sur PC est d’équilibrer performances et optimisation matérielle. Windows ML, basé sur ONNX Runtime, offre une solution à ce problème en se connectant de manière transparente à une couche d’exécution d’IA optimisée fournie par chaque fabricant de matériel. Pour les GPU GeForce RTX, Windows ML utilise automatiquement la bibliothèque d’inférence TensorRT for RTX pour des performances élevées et un déploiement rapide. Selon NVIDIA, TensorRT offre des performances jusqu’à 50% plus rapides pour les charges de travail d’IA sur PC par rapport à DirectML. Plus d’informations sur les performances de TensorRT pour RTX.

Windows ML simplifie également le travail des développeurs en sélectionnant automatiquement le matériel approprié (GPU, CPU ou NPU) pour exécuter chaque fonctionnalité d’IA et en téléchargeant le fournisseur d’exécution pour ce matériel. Cela élimine la nécessité d’intégrer ces fichiers dans l’application, permettant ainsi aux utilisateurs de bénéficier des dernières optimisations de TensorRT dès qu’elles sont disponibles. TensorRT, initialement conçu pour les centres de données, a été repensé pour les RTX AI PCs. Au lieu de générer des moteurs TensorRT à l’avance, TensorRT for RTX utilise une construction d’engines « just-in-time » sur l’appareil pour optimiser le modèle d’IA pour le GPU RTX spécifique de l’utilisateur en quelques secondes. La taille de la bibliothèque a également été réduite de manière significative, ce qui facilite son intégration dans les applications. Les développeurs peuvent accéder à TensorRT for RTX via la version préliminaire de Windows ML dès aujourd’hui et via un SDK autonome sur NVIDIA Developer en juin. Plus d’informations sur TensorRT pour RTX.

Élargissement de l’Écosystème d’IA sur Windows 11

NVIDIA met à disposition une large gamme de SDK pour aider les développeurs à intégrer des fonctionnalités d’IA ou à améliorer les performances de leurs applications. Ces SDK incluent NVIDIA CUDA et TensorRT pour l’accélération GPU, NVIDIA DLSS et OptiX pour les graphiques 3D, NVIDIA RTX Video et Maxine pour le multimédia, et NVIDIA Riva et ACE pour l’IA générative. Plusieurs applications majeures publient des mises à jour ce mois-ci pour activer des fonctionnalités uniques grâce à ces SDK.

- LM Studio : mise à jour vers la dernière version de CUDA, augmentant les performances de plus de 30%.

- Topaz Labs : sortie d’un modèle vidéo d’IA générative pour améliorer la qualité vidéo, accéléré par CUDA.

- Chaos Enscape et Autodesk VRED : ajout de DLSS 4 pour des performances plus rapides et une meilleure qualité d’image.

- Bilibili : intégration des fonctionnalités NVIDIA Broadcast, telles que l’arrière-plan virtuel, pour améliorer la qualité des diffusions en direct.

NVIDIA collabore avec Microsoft et les principaux développeurs d’applications d’IA pour accélérer leurs fonctionnalités d’IA sur les machines équipées de RTX grâce à l’intégration de Windows ML et TensorRT.

Faciliter l’IA Locale avec les Microservices NIM et les Blueprints IA

Pour faciliter l’accès à l’IA pour les développeurs, NVIDIA propose NVIDIA NIM, des modèles d’IA pré-empaquetés et optimisés. NIM simplifie le processus de développement en fournissant une liste de modèles d’IA sélectionnés, pré-empaquetés avec tous les fichiers nécessaires à leur exécution et optimisés pour des performances maximales sur les GPU RTX. Ces microservices conteneurisés peuvent être exécutés de manière transparente sur PC ou dans le cloud. Les microservices NVIDIA NIM sont disponibles en téléchargement via build.nvidia.com ou via des applications d’IA populaires telles que Anything LLM, ComfyUI et AI Toolkit pour Visual Studio Code. NVIDIA prévoit de publier le microservice FLUX.1-schnell, un modèle de génération d’images de Black Forest Labs, et de mettre à jour le microservice FLUX.1-dev pour une compatibilité accrue avec les GPU GeForce RTX 50 et 40 Series. Plus d’informations sur NVIDIA NIM.

Les développeurs d’IA peuvent également s’appuyer sur les NVIDIA AI Blueprints, des exemples de flux de travail et de projets utilisant les microservices NIM. NVIDIA a récemment publié l’NVIDIA AI Blueprint pour l’IA générative guidée en 3D, permettant de contrôler la composition et les angles de caméra des images générées en utilisant une scène 3D comme référence. Plus d’informations sur les NVIDIA AI Blueprints.

Project G-Assist : L’Assistant IA pour PC RTX

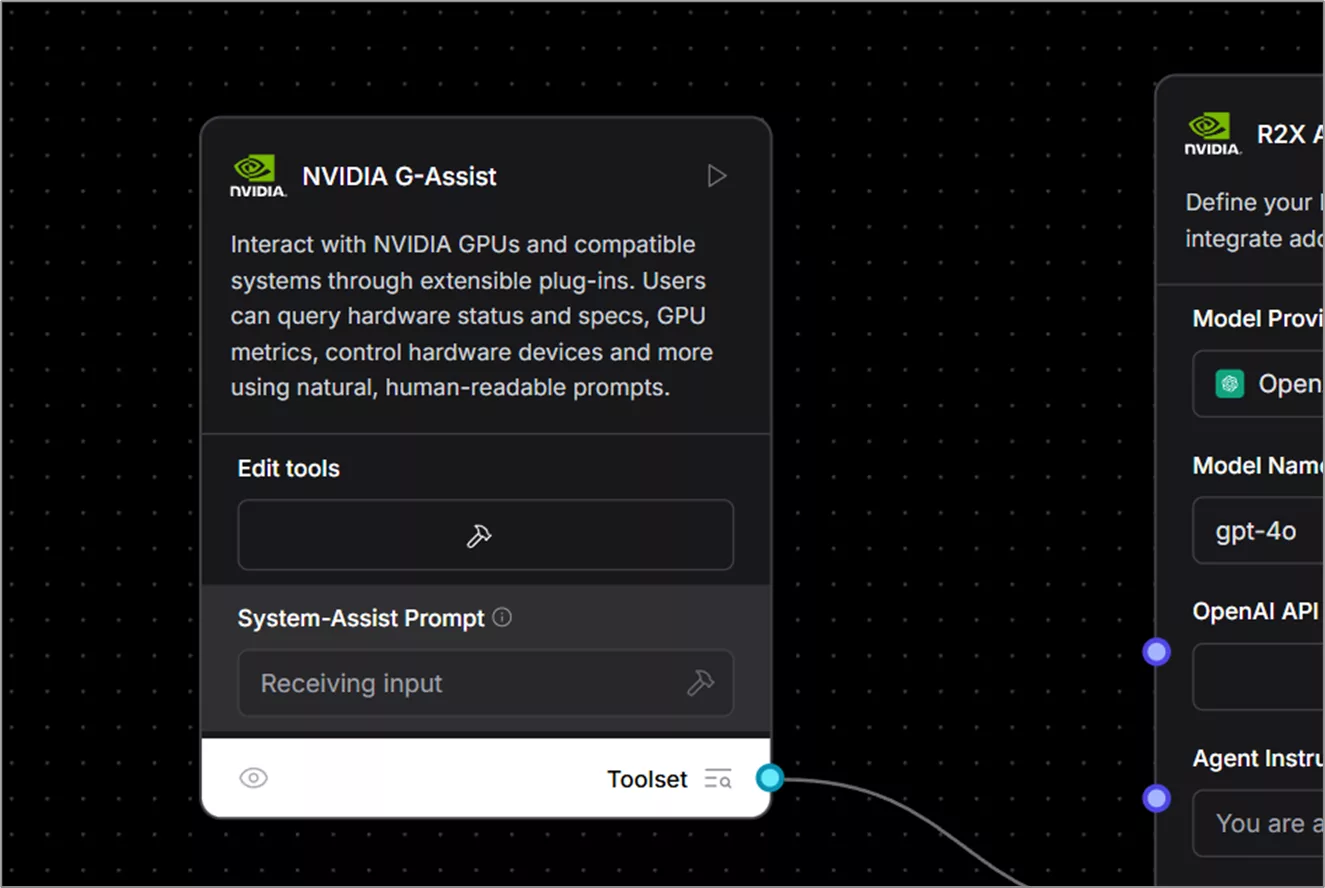

NVIDIA a récemment lancé Project G-Assist, un assistant IA expérimental intégré à l’application NVIDIA. G-Assist permet aux utilisateurs de contrôler leur système GeForce RTX à l’aide de commandes vocales et textuelles simples, offrant une interface plus conviviale. Les développeurs peuvent également utiliser Project G-Assist pour créer facilement des plug-ins, tester des cas d’utilisation et les publier via Discord et GitHub. Le Project G-Assist Plug-in Builder, une application basée sur ChatGPT, facilite le développement sans code ou à faible code avec des commandes en langage naturel. De nouveaux exemples de plug-ins open source sont disponibles sur GitHub, démontrant diverses façons dont l’IA sur l’appareil peut améliorer les flux de travail des PC et des jeux.

Les exemples de plug-ins incluent :

- Gemini : mis à jour pour inclure des capacités de recherche Web en temps réel.

- IFTTT : permet de créer des automatisations pour déclencher des routines IoT.

- Discord : permet de partager facilement des moments forts de jeux ou des messages directement sur les serveurs Discord.

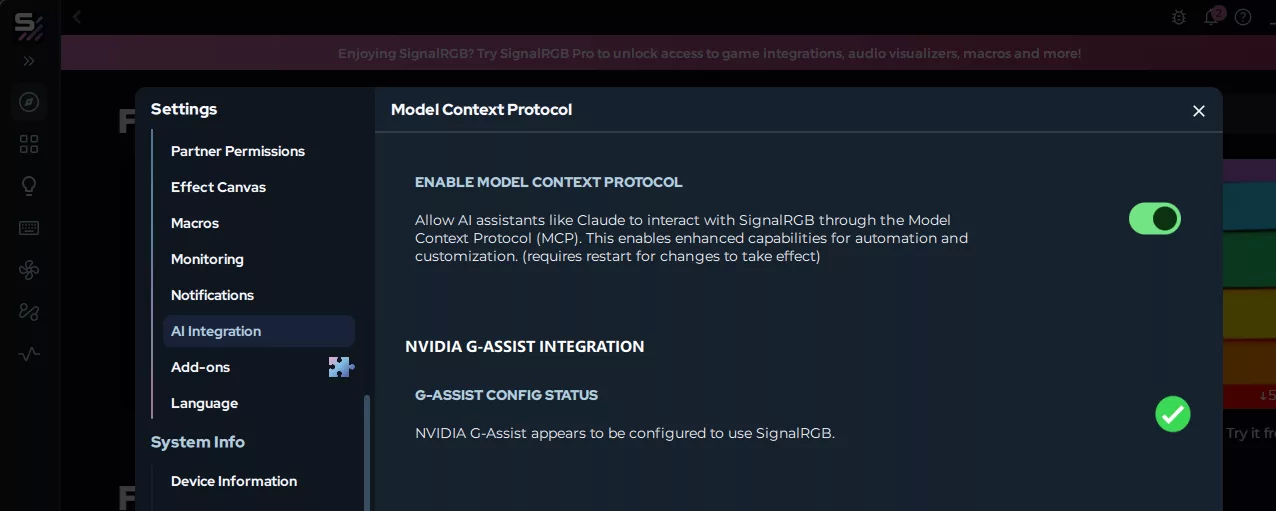

SignalRGB développe un plug-in G-Assist pour un contrôle unifié de l’éclairage multi-fabricants. La communauté IA pourra bientôt utiliser G-Assist comme composant personnalisé dans Langflow, permettant d’intégrer des fonctionnalités d’appel de fonctions dans des flux de travail sans code ou à faible code. Plus d’informations sur Project G-Assist.

Pour rester informé des dernières avancées en matière d’IA sur RTX, les utilisateurs sont encouragés à s’abonner à la newsletter RTX AI PC et à suivre NVIDIA sur les réseaux sociaux. [Rejoignez la communauté NVIDIA](https://www.nvidia.com/en-us/ai-