L’intérêt pour l’intelligence artificielle générative (IA générative), notamment grâce à des modèles toujours plus performants, ne cesse de croître. Désormais, même les passionnés sans compétences en développement peuvent s’immerger dans ce domaine en pleine expansion. Grâce à des applications populaires comme Langflow, une plateforme visuelle à faible code pour la conception de flux de travail d’IA personnalisés, les utilisateurs peuvent créer des agents d’IA performants. L’intégration native d’Ollama permet de créer des flux de travail d’IA locaux, exécutables sans frais et en toute confidentialité, le tout propulsé par les GPU NVIDIA GeForce RTX et RTX PRO. Cet article explore en détail comment Langflow et les GPU RTX ouvrent de nouvelles perspectives pour la création d’agents d’IA personnalisés.

L’émergence de l’IA générative marque un tournant dans l’industrie technologique. L’accessibilité croissante de ces outils, combinée à la puissance des GPU, permet à chacun d’expérimenter et de développer des solutions innovantes. Langflow, en particulier, se positionne comme un outil clé pour démocratiser l’accès à l’IA, permettant aux utilisateurs de concevoir des flux de travail complexes sans nécessiter de compétences approfondies en programmation. De plus, la possibilité d’exécuter ces flux de travail localement, grâce à Ollama et aux GPU RTX, offre des avantages significatifs en termes de confidentialité, de coûts et de performance.

Flux de travail visuels pour l’IA générative

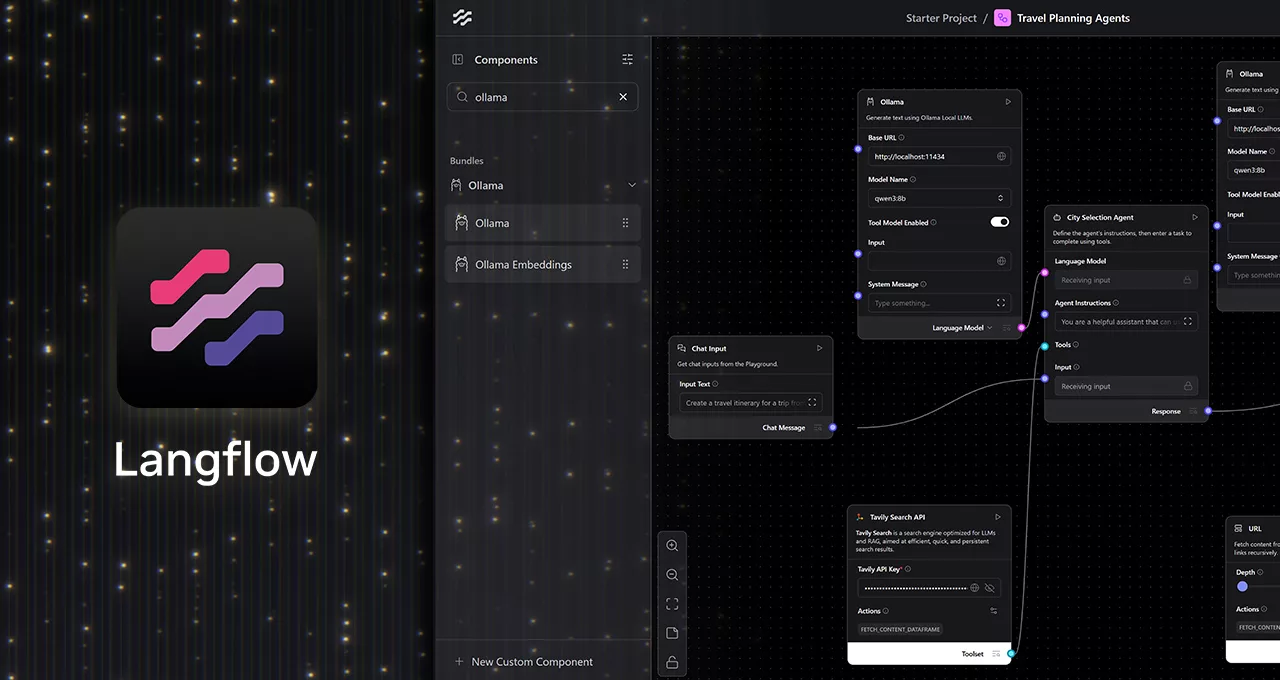

Langflow offre une interface intuitive de type « canevas » où les différents composants des modèles d’IA générative, tels que les grands modèles de langage (LLM), les outils, les mémoires et la logique de contrôle, peuvent être connectés par un simple glisser-déposer. Cette approche simplifie considérablement la création et la modification de flux de travail complexes, facilitant ainsi le développement d’agents capables de prendre des décisions et d’exécuter des actions en plusieurs étapes. Les passionnés d’IA peuvent ainsi itérer et concevoir des flux de travail complexes sans aucune expertise en codage. Contrairement aux applications limitées à l’exécution d’une seule requête LLM, Langflow permet de créer des flux de travail avancés qui se comportent comme des collaborateurs intelligents, capables d’analyser des fichiers, de récupérer des connaissances, d’exécuter des fonctions et de répondre de manière contextuelle à des entrées dynamiques. Pour en savoir plus sur l’IA générative, consultez la définition de l’IA générative par NVIDIA.

Création d’agents locaux avec Langflow et Ollama

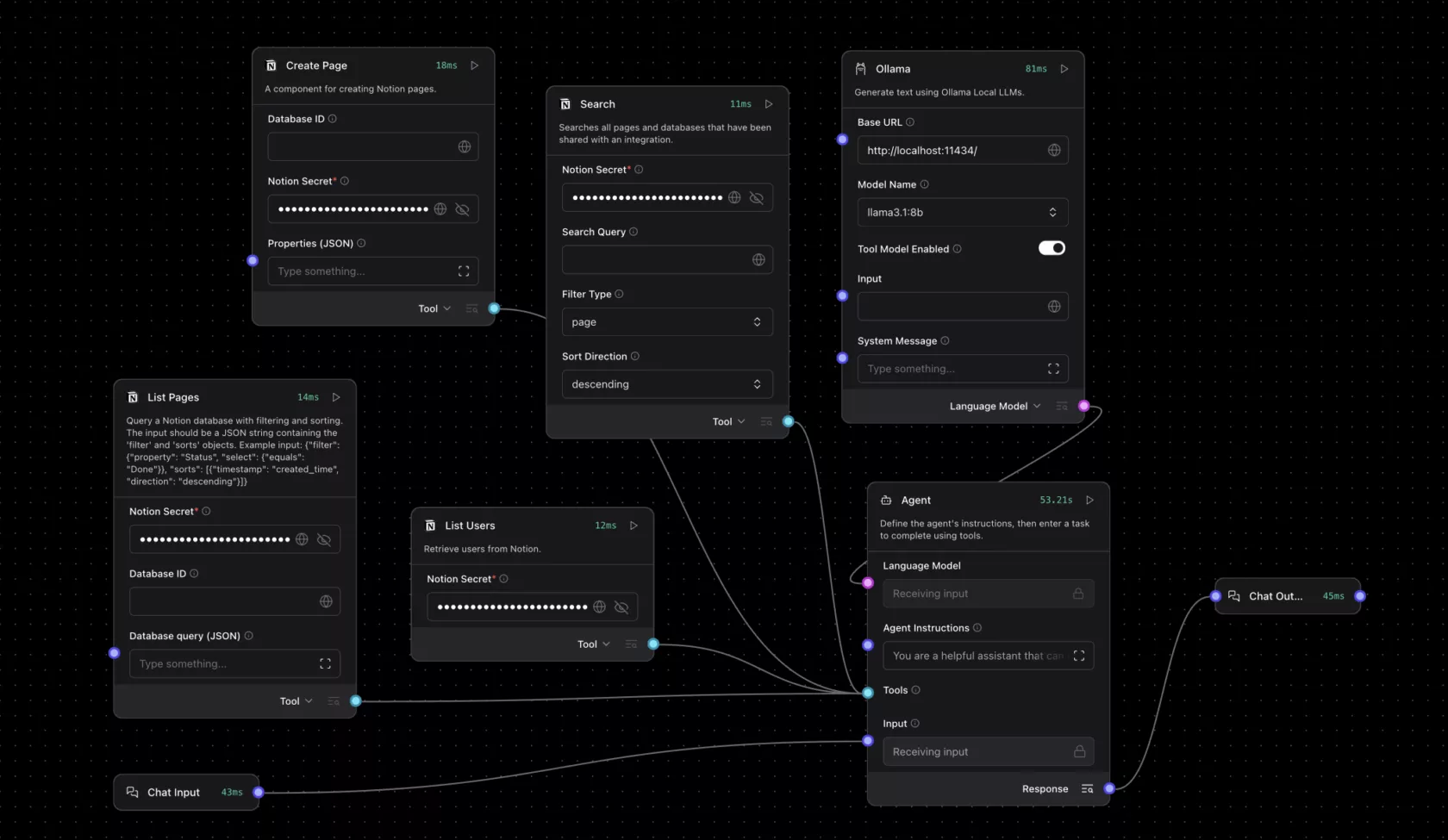

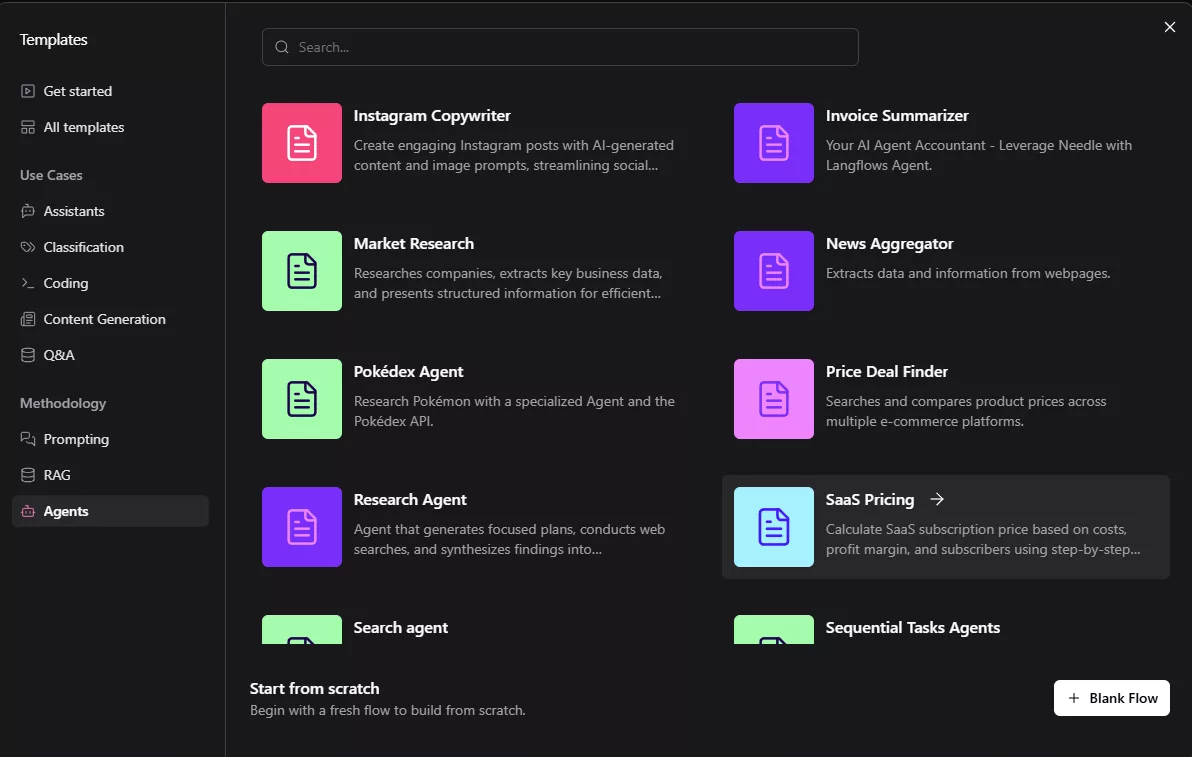

L’intégration d’Ollama dans Langflow est simple. Des modèles de démarrage sont disponibles pour divers cas d’utilisation, allant des agents de voyage aux assistants d’achat. Bien que ces modèles fonctionnent généralement dans le cloud à des fins de test, ils peuvent être personnalisés pour s’exécuter localement sur les GPU RTX grâce à Langflow. Les étapes pour créer un flux de travail local incluent l’installation de l’application de bureau Langflow pour Windows, l’installation d’Ollama, et le lancement du modèle préféré (Llama 3.1 8B ou Qwen3 4B recommandés pour les premiers essais). Ensuite, il suffit d’exécuter Langflow et de sélectionner un modèle de démarrage, puis de remplacer les points de terminaison cloud par l’exécution locale d’Ollama. Pour les flux de travail basés sur des agents, le modèle de langage est défini sur « Personnalisé », un nœud Ollama est glissé sur le canevas, et la sortie du modèle personnalisé de l’agent est connectée à la sortie « Modèle de langage » du nœud Ollama.

Les modèles peuvent être modifiés et étendus en ajoutant des commandes système, une recherche de fichiers locaux ou des sorties structurées pour répondre à des besoins d’automatisation et d’assistance plus avancés. Les avantages de l’exécution locale sont nombreux : confidentialité des données, absence de coûts d’API et de restrictions de jetons, performances optimisées grâce aux GPU RTX, et fonctionnalité hors ligne. Pour ceux qui cherchent à approfondir, NVIDIA propose de nombreuses ressources, y compris des exemples de projets pour créer un agent d’itinéraire de voyage personnalisé ou pour étendre les capacités de Notion.

RTX Remix et le protocole de contexte de modèle : de nouvelles perspectives pour les moddeurs

RTX Remix, une plateforme open-source permettant aux moddeurs d’améliorer les matériaux avec des outils d’IA générative et de créer des remasters RTX époustouflants, intègre désormais le protocole de contexte de modèle (MCP) avec Langflow. Les nœuds Langflow dotés du MCP offrent aux utilisateurs une interface directe pour interagir avec RTX Remix, permettant aux moddeurs de créer des assistants de modding capables d’interagir intelligemment avec la documentation et les fonctions de Remix. NVIDIA propose un modèle Langflow Remix qui inclut un module de génération augmentée par récupération avec la documentation RTX Remix, un accès en temps réel à la documentation pour un support de type questions-réponses, et un module d’action via MCP qui prend en charge l’exécution directe de fonctions dans RTX Remix. Ces assistants de modding peuvent déterminer si une requête est informative ou orientée action, et répondre en conséquence, soit en fournissant des conseils, soit en effectuant l’action demandée. Pour plus d’informations sur RTX Remix, consultez les ressources dédiées.

L’intégration de Langflow dans RTX Remix ouvre de nouvelles possibilités pour les moddeurs, leur permettant d’automatiser des tâches complexes et d’améliorer significativement leurs flux de travail. En permettant aux agents d’IA d’interagir directement avec les fonctions de Remix, cette intégration offre un gain de temps considérable et une plus grande flexibilité dans la création de mods. Des outils comme Langflow et RTX Remix, combinés aux GPU GeForce RTX, offrent une puissance de calcul inégalée pour l’IA et le gaming, ouvrant la voie à des expériences toujours plus immersives et personnalisées.

Conclusion

L’alliance de Langflow, d’Ollama et des GPU NVIDIA GeForce RTX et RTX PRO représente une avancée significative dans le domaine de l’IA générative. Elle permet aux utilisateurs, même sans compétences en codage, de créer et d’exécuter des agents d’IA personnalisés de manière locale, sécurisée et performante. Que ce soit pour automatiser des tâches, améliorer les flux de travail de modding ou explorer de nouvelles applications, cette combinaison offre une flexibilité et une puissance sans précédent. Les perspectives d’avenir sont prometteuses, avec des améliorations continues des modèles d’IA, des outils de développement et des performances des GPU, ouvrant la voie à une adoption encore plus large de l’IA générative.

En conclusion, l’écosystème NVIDIA, avec des outils comme Langflow et RTX Remix, continue d’innover et de démocratiser l’accès à l’IA. Les GPU GeForce RTX, avec leur capacité à accélérer les charges de travail d’IA, restent au cœur de cette révolution. Les utilisateurs peuvent s’attendre à voir de nouvelles avancées et applications dans les mois à venir, stimulant ainsi la créativité et l’innovation dans de nombreux domaines. Pour suivre les dernières actualités et innovations, n’hésitez pas à consulter le blog RTX AI Garage et à vous connecter avec la communauté NVIDIA.